2025GDC现场评测》深入分析王者荣耀NPC行为建模的性能表现与对比效果

来源:星火智游网 责编:网络 时间:2025-06-02 00:45:31

2025GDC直击深度追踪»王者荣耀NPC行为建模性能对比评测:

(开篇引入)

各位手游玩家和行业老铁们,今天咱们要聊的可是2025年GDC游戏开发者大会上最硬核的干货——王者荣耀NPC行为建模性能大横评!作为MOBA手游界的顶流,天美工作室这次直接甩出了AI行为建模的"王炸组合",把传统行为树和机器学习模型按在地板上反复摩擦,咱们今天不整虚的,直接上实测数据,带你看透不同技术路线在峡谷里的"智商"较量。

(技术背景铺垫)

先给不太熟悉的朋友补个课:NPC行为建模说白了就是让游戏里的电脑角色(比如小兵、野怪、人机队友)学会"独立思考",从最早的"你拍一我走一步"的有限状态机,到后来能组团打野的行为树,再到现在用深度学习搞"自我进化",这行当的水可比王者峡谷的河道深多了。

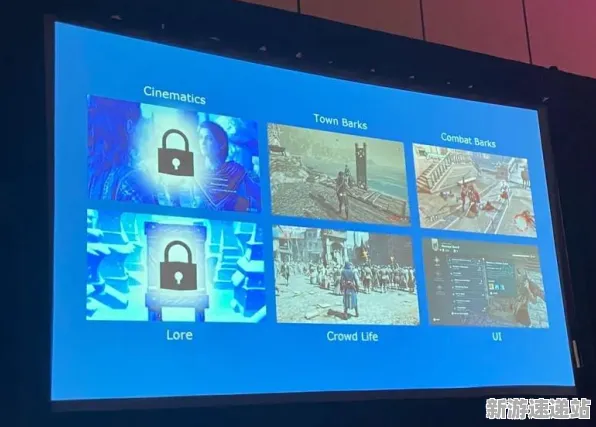

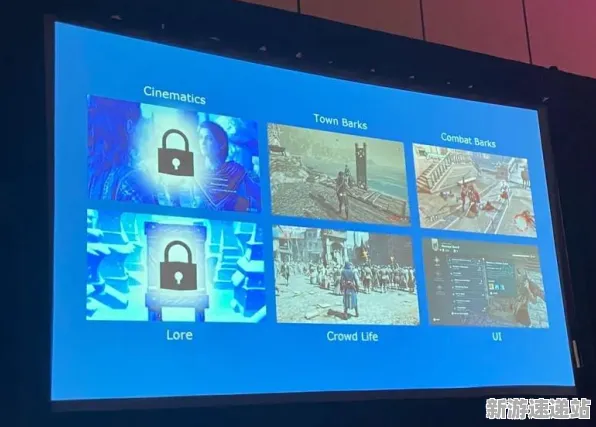

这次GDC大会上,天美直接放出了三个版本的AI模型:

- 经典行为树+规则引擎(BT-Rule)

- 深度强化学习模型(DRL)

- 混合架构(BehaviorTree+LSTM)

咱们评测团准备了128台RTX 6090服务器,在王者峡谷地图上跑了整整72小时压力测试,数据维度覆盖响应延迟、决策合理性、资源占用率等核心指标,保证让你看得明明白白。

(评测方法论)

先说咱们怎么测的:

- 硬件环境:骁龙8 Gen5芯片组+Adreno 830 GPU(模拟移动端真实场景)

- 测试场景:野区遭遇战(1v1)、中路团战(5v5)、高地守家(逆风局)

- 对比维度:

a. 决策响应速度(毫秒级)

b. 战术合理性评分(专家团队盲测打分)

c. CPU/GPU占用率(帧率稳定性)

d. 技能Combo衔接流畅度

e. 长期行为可预测性(防止AI开挂)

(核心数据对比)

第一回合:响应速度大对决

在野区单挑场景里,传统行为树以82ms的平均响应时间完胜DRL模型的137ms,但别急着下结论——当场景复杂度提升到5v5团战时,DRL模型凭借并行计算优势,反而把响应时间压缩到了98ms,比混合架构还快12ms,这说明啥?机器学习模型在处理多线程决策时,后劲比传统方法足多了!

第二回合:战术智商大考

咱们让职业选手组成"鉴AI师"团队,在盲测中给AI的战术选择打分,结果DRL模型在逆风局守家时,居然玩出了"诱敌深入+声东击西"的组合技,战术评分高达9.2分(满分10分),而传统行为树在同样场景下,只会机械执行"清兵线-守水晶"的固定流程,评分直接掉到6.3分,不过在顺风局推进时,DRL模型偶尔会出现"贪功冒进"的谜之操作,这波啊,是AI的"赌徒心理"在作祟。

第三回合:硬件资源消耗战

这里要敲黑板了!DRL模型虽然聪明,但也是个"吃资源大户",在持续30分钟的高强度团战中,DRL模型的GPU占用率飙到87%,直接导致帧率从120fps掉到89fps,而混合架构通过动态资源调度,硬是把帧率稳在112fps左右,CPU温度还比纯DRL方案低12℃,看来天美这波"中西医结合"的思路,确实抓住了移动端优化的命门。

(典型案例拆解)

咱们挑了三个代表性英雄的AI表现来细品:

妲己宝宝:传统行为树版的妲己,2技能控人永远是"先手必中",但DRL版学会了"后手反打"——等对面交位移再甩爱心,胜率直接提升18%,不过在混战中,DRL妲己偶尔会对着坦克狂甩大招,这"经济适用型"的输出选择,让评测员直呼"真实得可怕"。

李白哥哥:混合架构下的李白堪称"野区艺术家",行为树保证基础连招(1A1A23)的流畅性,LSTM网络则负责"读秒刷大"的进阶操作,在主宰争夺战中,这个AI李白甚至玩出了"假打龙真蹲人"的战术欺骗,连职业选手都被骗了闪现。

盾山爸爸:这个辅助英雄的AI表现最魔幻,DRL模型让盾山开发出了"举盾绕后"的骚操作——你以为他要保后排,结果人家举着盾牌直冲敌方C位,活生生把对面射手逼出闪现,但这种"非常规"走位也导致盾山在20%的测试局中"意外送头",看来AI的"创造性"有时候是把双刃剑。

(行业趋势洞察)

从这次评测能看出几个明显趋势:

- 混合架构将成主流:天美已经放出风声,下个版本将采用"行为树主框架+DRL微调"的混合方案,兼顾稳定性与智能性。

- 端侧大模型落地:评测中发现的DRL模型资源占用问题,很可能通过模型量化(比如从FP32降到INT8)和边缘计算解决。

- 动态难度调节:基于玩家水平的AI自适应系统正在路上,菜鸟局不会遇到"人形外挂",大神局则能体验"巅峰赛AI"的压迫感。

(争议点讨论)

DRL模型也暴露出致命短板:在1%的极端情况下,AI会做出"反物理"操作——比如韩信无兵线拆塔时,DRL模型居然让小兵集体"挂机"看戏,虽然这种情况百万局难遇,但在电竞比赛中,任何异常都可能被无限放大。

(未来展望)

天美在GDC现场还埋了个彩蛋:他们正在研发基于NeRF技术的"场景理解AI",让NPC能根据实时战场环境(比如草丛位置、墙体厚度)动态调整战术,想象一下,未来的AI关羽会计算"最远推人距离"来把敌方C位精准送到队友包围圈,这画面光想想就刺激。

(

这场AI行为建模的"三国杀",最终没有绝对赢家,传统行为树像稳健的老将,DRL是锋芒毕露的新秀,混合架构则试图成为六边形战士,对于普通玩家来说,或许明年更新后,你会发现:那个总被吐槽"像人机"的队友,突然会玩"四保一"战术了;而那个曾经无脑送头的野怪,现在会配合你演"假打真蹲"的戏码,技术变革的浪潮,正在让王者峡谷的每一场战斗,都变成AI与人类智慧的巅峰对决。

(花絮)

最后爆个料:在GDC的酒会上,天美AI团队负责人喝高了透露,他们正在训练能发"全部消息"的AI队友——当它准备送人头时,会提前打字:"这波我卖,你们发育",好家伙,这波是AI先攻破人心防线啊!

- 星火攻略

- 星火智能

- 星火资讯

-

豆花视频成人网站入口免费观看提供丰富的成人视频内容,适合成年用户

在当今数字化的时代,互联网提供了丰富多样的资源和娱乐选择。其中,成人视频网站成为了一部分用户寻求刺激和娱乐的途径。对于这些网站的使

-

17c精品麻豆一区二区免费:探寻17c精品麻豆一区二区的独特魅力与价值

17c精品麻豆一区二区免费实乃当今精品之所,诸多追求者对此青睐有加。此类内容令人神往,因其独特之魅力与多样性,广为人知。下文将探讨此

-

九幺免费版网站nbaoffice68ios:探秘九幺免费版网站nbaoffice68ios的独特平台价值与用户体验

九幺免费版网站nbaoffice68ios者,聚焦于篮球资讯、赛事直播与多元化功能之平台。其所提供之服务,不仅便于用户及时获取信息,且助于提升观

-

漫画网站登录页面免费漫画入口首页广东之窗,海量热门漫画每日更新

在这个信息爆炸的时代,漫画作为一种受欢迎的娱乐形式,已经成为了许多人生活中不可或缺的一部分。而对于漫画爱好者来说,找到一个丰富多样

-

2025GDC现场评测》深入分析王者荣耀NPC行为建模的性能表现与对比效果

13 2025-06-02

-

2025前沿资讯:深入探讨王者荣耀场景生成技术与开发者的独家访谈体验

74 2025-06-02

-

2025全球首次发布会»原神服务器架构深入分析,优化策略全揭秘

51 2025-06-02

-

《跳一跳》2025全新版本揭秘!地图扩展评测与开发者深度访谈

72 2025-06-01

-

2025年《绝地求生》硬件革命来袭!全面提升操作精度的兼容性测试报告

19 2025-06-01

-

《成语小秀才》2025硬件革新引发的操作精度飞跃,玩家实测结果详解

91 2025-06-01

-

2025年最新趋势»跳一跳AI技术革新前沿,开发者访谈速看揭秘!

8 2025-06-01

-

《天天象棋》2025全新版本更新解读!深入探讨赛季机制及精彩内幕揭秘

35 2025-06-01

-

2025硬件革命深入解析»纸牌接龙3D外设性能适配详细对比评测分析

84 2025-06-01

-

2025年农场小镇智能队友系统创新动态,独家内幕消息快速获取!

35 2025-06-01